2025年7月14日、Cloudflareが提供する高速・セキュアなパブリックDNSサービス「1.1.1.1」に世界規模で障害が発生し、約1時間にわたりサービスが停止する事態となりました。

このインシデントは一部のインターネット接続ユーザーにとってDNS解決が行えない状態を引き起こし、Webブラウジングやアプリ使用に支障が出た可能性があります。

🚧障害の原因は「プレフィックス設定ミス」

Cloudflareによると、障害の直接的な原因は、誤ったネットワークプレフィックス構成の適用でした。

実際には、以下のような経緯で問題が発生しています:

- 2025年6月6日:将来の「DLS(データローカライゼーションスイート)」向けの構成準備が行われた際、誤って「1.1.1.1」に関連するプレフィックスが含まれてしまう。

- 当時は未反映だったため問題は発生せず。

- 2025年7月14日21:48(UTC):DLSの本番構成が適用され、世界中のCloudflareデータセンターから「1.1.1.1」関連プレフィックスが削除され始める。

- 21:52:実際のトラフィック減少が観測され、障害が顕在化。

- 22:01:監視システムがアラートを発し、インシデントが正式に認定される。

⏱62分間におよぶ影響と復旧プロセス

障害発生から復旧までのタイムラインは以下のとおりです:

- 22:20:構成の書き戻しを手動で実施。事前にテスト済み。

- 22:54:DNSトラフィックが正常に戻り、インシデントは解消。

Cloudflareによれば、この構成ミスにより「1.1.1.1」宛てのDNSリクエストはBGPルート(Border Gateway Protocol)レベルで遮断された状態となり、結果として多数のユーザーが名前解決に失敗したと推定されます。

なお、同時間帯に「1.1.1.0/24」のBGPハイジャックが観測されましたが、これは今回の障害とは直接の関係はないと明言されています。

📶トラフィックの影響とプロトコル別の差

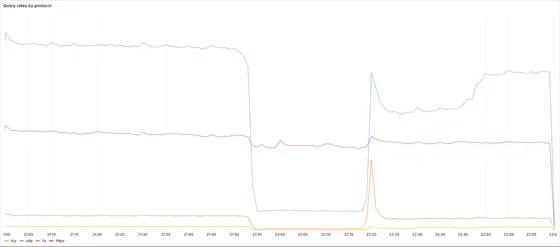

Cloudflareが公表したプロトコル別のクエリ量によれば、障害発生直後に次のような変化が見られました:

- 🔵 UDP/TCPベースの通常DNSクエリ:急激に減少

- 🔐 DoH(DNS over HTTPS):比較的安定

これは、DoHユーザーがドメインベースのアクセスを行っていることが要因で、BGPレベルの影響を一部受けにくかったと考えられます。

🛡️DNSの信頼性とリスクを再認識

Cloudflareの「1.1.1.1」は、高速・プライバシー重視を掲げるパブリックDNSサービスとして、多くのユーザーに支持されています。しかし、今回のようにルーティングレベルでの設定ミスにより、大規模な障害が発生することはDNSインフラの脆弱性を改めて浮き彫りにしました。

DNSはインターネットの「住所録」のような存在であり、ひとたび障害が起こればほぼすべてのネット通信に波及します。

Cloudflareは今後、構成の自動検証や段階的適用の強化など、再発防止策の徹底を約束しています。

🧠今回の障害から学べるポイント

- ✅ ネットワーク構成の変更は、過去の設定参照を含めて慎重に行う必要がある

- ✅ パブリックDNSでも100%の可用性は保証できない

- ✅ DNS障害時の対策として、セカンダリDNS(例:Googleの8.8.8.8)設定が推奨される

- ✅ UDPベースDNSよりも、HTTPSベースのDoHは復旧耐性が高い可能性も

📌まとめ:1.1.1.1は信頼性が高いが、万能ではない

Cloudflareは、ユーザーのプライバシー保護やパフォーマンス向上のために革新的なDNS技術を提供してきましたが、今回の障害は人為的ミスによる設定誤りであったことが明らかです。

DNSというインフラの根幹に関わる技術において、わずかな構成ミスが数千万規模の影響を及ぼす可能性があることを改めて認識すべきでしょう。