― O4-miniに匹敵する推論力を持つオープンモデル、MITライセンスで無料公開

中国発のAI開発企業DeepSeekが、次世代大規模言語モデル「DeepSeek-R1-0528」を公開しました。

同モデルは、先行版R1のマイナーアップデートに位置付けられますが、その実力はOpenAIのo4-mini(medium)に並ぶ水準とされており、AI業界・研究者の注目を集めています。

🔍 DeepSeek-R1-0528とは?

- パラメータ数:6850億(R1より増加)

- 公開日:2025年5月28日(モデル名に由来)

- ライセンス:MIT(商用・研究利用自由)

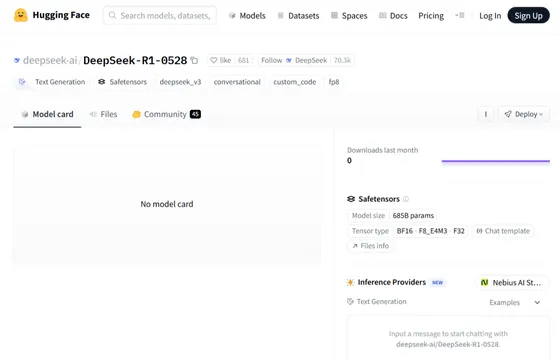

- 配布元:Hugging Face(モデルページはこちら)

モデル本体はHugging Faceにて重みと設定ファイルが公開されており、説明文は付属していません。推論環境のカスタマイズは開発者に委ねられています。

🧠 アップデートの主な特徴

DeepSeek R1-0528のアップデートは主に推論能力の向上に焦点を当てており、以下のような進化が見られます。

✔️ 1. 推論の深みが大幅向上

「Googleのモデルのような深い思考フローを持つようになった」と開発チームは表現。

単に高速で答えるのではなく、文脈を踏まえた熟考型の応答が得られるのが特徴です。

✔️ 2. 長時間の思考セッションに対応

1つのタスクに最大30〜60分かけてじっくりと検討する力があり、難解な論文や設計問題への適性が高まっています。

✔️ 3. コード生成タスクの精度向上

コードの補完・修正・出力予測といった幅広いプログラミング課題においても、自然でフォーマットに忠実な出力を示します。

📊 LiveCodeBenchでも上位ランク入り

AIのコード生成性能を評価するベンチマーク「LiveCodeBench」では、DeepSeek-R1-0528は記事執筆時点で4位にランクイン。

これは、OpenAIのo4-mini(medium)モデルとほぼ同等のスコアであり、実用面での有望さを示すデータといえます。

🏆 評価期間:2024年8月1日〜2025年5月1日

🔗 LiveCodeBench 最新ランキングを見る

📘 「Attention Is All You Need」も読解可能

R1-0528は、Transformerアーキテクチャを定義した論文「Attention Is All You Need」を読み、

その内容を論理的かつ構造的に要約できるレベルの理解力を持ちます。

これは、研究者向けの文献読解ツール「PapersGPT」との連携により実証されており、

論文読解AIとしても活躍が期待されています。

📂 モデル入手・試用情報

- 🤖 モデル名:

deepseek-ai/DeepSeek-R1-0528 - 🔗 Hugging Face リポジトリ:

https://huggingface.co/deepseek-ai/DeepSeek-R1-0528 - 🧪 ライセンス:MIT(商用・非商用利用可)

- 💻 対応環境:Transformersベースの推論環境(GPU推奨)

🌐 DeepSeekと関連する話題

- 🧮 数学証明に特化した「DeepSeek-Prover-V2」も公開済み

- 🧠 清華大学との共同研究で推論強化手法を開発

- ⚙️ Tencentが競合モデル「Hunyuan T1」をリリースし、性能・価格で競争激化

- 🇨🇳 一部米国筋はDeepSeekを「中国共産党の影響下」として懸念視

📝 まとめ:R1-0528は“深く考えるオープンモデル”の象徴

DeepSeek-R1-0528は、商用モデルに匹敵する推論力をオープンに提供する、まさに“GPT時代のBERT”的存在です。

特に、コード生成や研究読解タスクに強く、企業・研究機関にとって即戦力となるモデルといえるでしょう。

🔧 実装テストや評価が未定の方も、まずは軽量環境で触ってみる価値ありです。